whatsapp只能手机号添加吗

纸面参数很高大上,号称原生多模态 MOE 模型,击败 DeepSeek V3,还有 2 万亿参数巨兽,连 Meta CEO 扎克伯格也发视频,摇旗高呼迎接「Llama 4 日」。

欢呼是短暂的,当网友开始实测后,却几乎是一边倒的负面评价,堪称今年 AI 界最大的「翻车」事件。

在专门讨论本地部署大语言模型的社区 r/LocalLLaMA(可理解为 Llama「贴吧」)中,一篇标题为「我对 Llama 4 感到 incredibly disappointed(极度失望)」的帖子迅速获得了大量关注和共鸣。

更有 Llama 忠实粉丝原地破防,直言是时候该将「LocalLLaMA」改名为「LocalGemma」了,调侃 Llama 4 的发布更像是迟到的愚人节玩笑。

这一基准测试旨在评估大型语言模型(LLM)在多语言编程任务中的表现,覆盖了 C++、Go、Java、JavaScript、Python 和 Rust 六种主流编程语言。

博主 @deedydas 同样表达了对 Llama 4 的失望,直呼其为「一个糟糕透顶的编程模型」。

另一位网友 Flavio Adamo 分别让 Llama 4 Maverick 和 GPT-4o 生成一个小球在旋转多边形弹跳的动画,并且,小球跳动的过程中要遵循重力和摩擦力的影响。

结果显示,Llama 4 Maverick 生成的多边形形状缺乏开口,小球的运动也违背物理规律,相比之下,新版 GPT-4o 的表现明显更胜一筹,而 Gemini 2.5 Pro 的表现则堪称王者。

回望今年 1 月,扎克伯格还宣称,AI 将达中级软件工程师编程水平,就目前 Llama 4 糟糕的表现,属实是打脸来的有些快。

另外,Llama 4 Scout 的上下文长度达到了 1000 万 tokens。这一超长上下文长度使得 Llama 4 Scout 能够处理和分析极长的文本内容,例如整本书籍、大型代码库或多媒体档案。

这意味着,如果你把整本书输入模型,然后问「哈利小时候是住在卧室还是楼梯下的储物间」,Llama-4-Scout 只有 22% 的概率能答对(近似理解,实际召回机制更复杂)。而这个成绩自然也就远低于头部模型的平均水平。

Meta 开放了 Llama 4 的权重,但即使使用量化(quant),也无法在消费级 GPU 上运行。号称单卡运行,但实际指的却是 H100。门槛之高,对开发者可谓是相当不友好。

更何况,Llama 4 的新许可证还有几个限制条款,其中备受诟病的则是拥有超过 7 亿月活跃用户的公司必须向 Meta 申请特别许可证,Meta 可以自行决定是否批准或拒绝。

在大模型竞技场(Arena)排名中,Llama 4 Maverick 名列总榜第二,成为第四个突破 1400 分的模型,在开源模型中更是高居榜首,更是超越了 DeepSeek V3。

面对实测性能的「货不对板」,细心的网友很快嗅到一丝蹊跷。在 LM Arena 上取得高分的 Maverick 其实用到了一个「实验性聊天版本」。

这还没完,今天一亩三分地社区的爆料贴也似乎揭开了一些内幕。爆料称,经过反复训练后,Llama 4 未能取得开源 SOTA,甚至与之相差甚远。

于是,公司领导层建议将各个 benchmark 的测试集混合在 post-training 过程中,目的是希望能够在各项指标上交差。拿出一个「看起来可以」的结果。

这里说的将各个 benchmark 的测试集混合在 post-training 过程中,是指在模型的后训练(post-training)阶段,通过混合不同基准测试的数据集,模型可以在多种任务和场景中学习,从而提升其泛化能力。

打个简单的比方,这就像考试时作弊。试题本该从保密题库(benchmark 测试集)中随机抽取,考前无人知晓。可如果有人提前偷看了题目并反复练习(相当于将测试集混入训练),那考试的时候肯定能考得很好。

帖主进一步解释说,Llama 4 发布之后,实测结果遭到 X 和 Reddit 网友的吐槽。作为一名目前也在学术界的人他宣称实在无法接受 Meta 的做法,已提交离职申请,并明确要求在 Llama 4 的 Technical Report 中剔除自己的名字。

不过,对于这桩疑似「刷榜作弊」的指控,真相究竟如何,或许还需更多证据。一位名为 LichengYu 的 Meta 员工也疑似在评论区实名回应称:

「这两天虚心聆听各方 feedback(比如 coding,creativewriting 等缺陷必须改进),希望能在下一版有提升。但为了刷点而 overfit 测试集whatsapp只能手机号添加吗,我们从来没有做过,实名 Licheng Yu,两个 oss model 的 post training 有经手我这边。请告知哪条 prompt 是测试集选出来放进训练集的,我给你磕一个+道歉!」

公开资料显示,Licheng Yu(虞立成)曾本科毕业于上海交通大学,2014 年获佐治亚理工学院和上海交通大学双硕士学位,在 2019 年 5 月获北卡罗来纳大学教堂山分校计算机科学博士学位,。

他的研究领域专注于计算机视觉和自然语言处理,多篇论文被 CVPR、ICLR、ECCV、KDD 等顶级会议接收。

当然,脱下简单的灰色T恤、牛仔裤和连帽衫,扎克伯格也开始频繁地穿着大 LOGO 的名牌服装,颈间挂上粗犷的大金链子,甚至在公开场合自信展示自己的健身成果。

醉翁之意不在酒的扎克伯格试图通过展现更「真实」、更「接地气」的一面,拉近与公众的距离。这不仅让 Meta 显得更加亲民,也使其顺势成为对抗 OpenAI 闭源模型的开源旗手,声势一时无两。

与此同时,Meta 的雄厚实力为转型提供了坚实后盾。据悉,Meta 计划在 2025 年投入高达 650 亿美元用于扩展其 AI 基础设施,这一数字在业内堪称大手笔,到 2025 年底,Meta 计划拥有超过 130 万块 GPU。

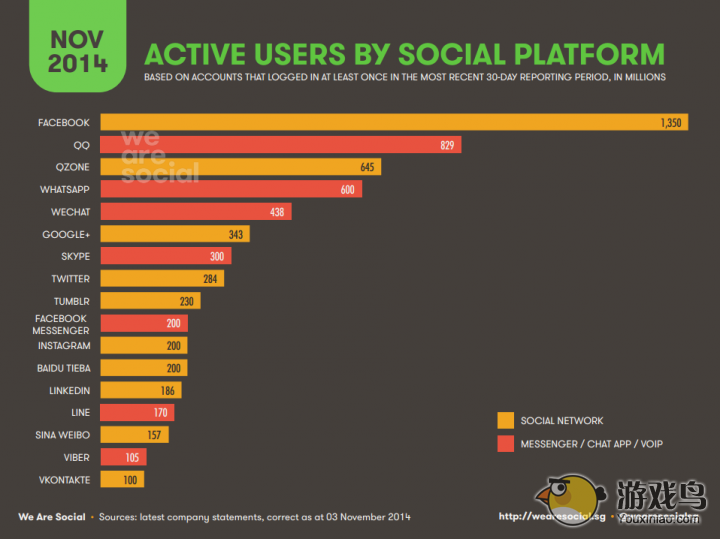

作为 Facebook、Instagram 和 WhatsApp 等全球知名社交平台的母公司,Meta 掌握着数十亿用户的日常交互数据。据统计,其平台的全球日活跃用户数(DAU)在 2024 年已超过 30 亿,这一庞大的数据体量为 AI 模型的训练提供了海量的原材料。

再者,Meta 在人才储备上同样不遑多让。其 AI 部门的领军人物是业界享有盛誉的图灵奖得主 Yann LeCun。在他的带领下,Meta 坚持开源策略,推出了 Llama 系列模型。

因此,Meta 也野心十足——它不仅要巩固自身在社交领域的地位,更希望在 AI 领域实现弯道超车,目标是在 2025 年底前超越 OpenAI 等强劲对手。

若一亩三分地的爆料属实,Llama 4 的研发过程中可能存在为追求基准测试分数而「作弊」的行为——通过将测试集混入训练数据,也更像是「AI 流量焦虑」下的操作变形。

「当生成式 AI 组织中的每个高管薪资都比训练整个 DeepSeek-V3 的成本还要高,而我们有好几十个这样的高管,他们要如何面对高层?」

2023 年,Meta 凭借 Llama 系列在开源大模型领域几乎建立了垄断地位,成为开源 AI 的代名词和标杆。

然而,AI 一日,人间一年,在 Llama 4 遭遇「滑铁卢」的评论区中,其他开源模型的好评随处可见。其中,Google Gemma 以轻量高效和多模态能力赢得广泛认可,阿里的 Qwen 系列基座模型崭露头角,而 DeepSeek 更以低成本高性能的黑马姿态震撼了整个行业。

Meta 能否调整策略重回开源 AI 的模型领跑位置尚未可知,但无论如何,开源 AI 的百花齐放已经不可逆转地到来了。

秉持着哪个 AI 好用,用哪个的原则,Meta 也不能全然怪用户「墙头草」。更何况,在开源透明度方面,相较于上述几家公司的开源模型,Llama 4 的自缚手脚,也颇有些自断一臂的意味。

而 Meta 目前的挣扎或许也表明,即便手握全球所有的 GPU 算力和海量数据,资源优势已不再是决定性因素,开源大模型的「王座」,不能靠蛮力夺取。